Nvidia выпустила новое поколение платформы Rubin, стоимость инференса снижена в 10 раз по сравнению с Blackwell, планируется поставка во второй половине года

Nvidia представила на выставке CES новое поколение AI-платформы Rubin, что свидетельствует о сохранении ежегодного цикла обновлений в области чипов для искусственного интеллекта. Платформа, созданная на базе интеграции шести новых чипов, значительно повысила эффективность обучения и снизила стоимость инференса, а первые поставки клиентам запланированы на вторую половину 2026 года.

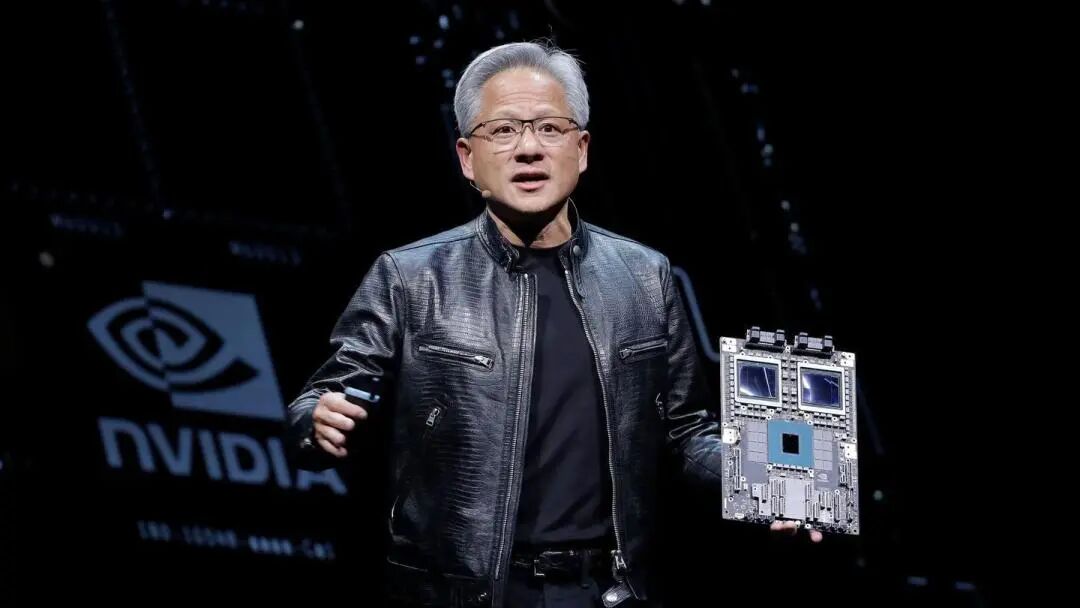

5 числа по восточному времени США, в понедельник, генеральный директор Nvidia Дженсен Хуанг в Лас-Вегасе сообщил, что шесть чипов Rubin уже вернулись от производственных партнеров и прошли часть ключевых тестов, проект движется в соответствии с планом. Он отметил: «AI-гонка уже началась, и все стараются выйти на следующий уровень». Nvidia подчеркнула, что эксплуатационные расходы систем на Rubin будут ниже, чем у версий Blackwell, так как для достижения тех же результатов требуется меньше компонентов.

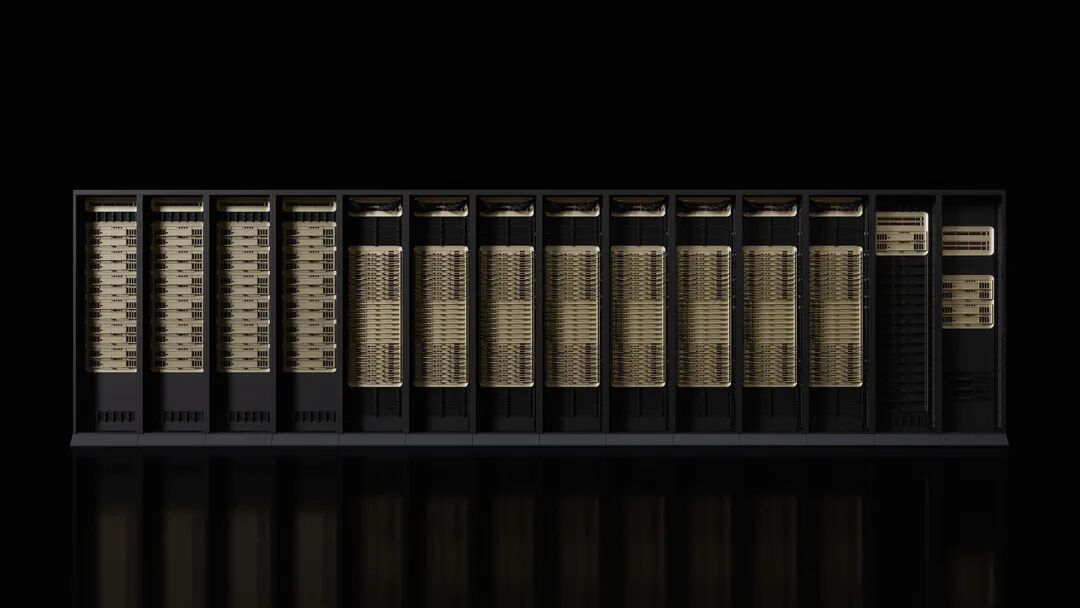

Microsoft и другие крупные облачные провайдеры станут первыми клиентами, внедряющими новое оборудование во второй половине года. Следующее поколение AI-суперфабрики Fairwater от Microsoft будет оснащено системой Nvidia Vera Rubin NVL72 на уровне стойки, масштабируемой до сотен тысяч чипов Nvidia Vera Rubin. CoreWeave также станет одним из первых поставщиков систем Rubin.

Запуск платформы совпал с ростом опасений на Уолл-стрит по поводу усиления конкуренции для Nvidia и сомнений в том, что расходы в AI-секторе смогут поддерживать текущие темпы. Однако Nvidia сохраняет оптимистичный долгосрочный прогноз, полагая, что общий размер рынка может достигнуть триллионов долларов.

Увеличение производительности для новых потребностей AI

Согласно заявлению Nvidia, производительность обучения на платформе Rubin в 3,5 раза выше, чем на предыдущем поколении Blackwell, а производительность при запуске AI-программ увеличена в 5 раз. По сравнению с платформой Blackwell, Rubin может снизить стоимость генерации токенов при инференсе до 10 раз и уменьшить необходимое количество GPU для обучения моделей Mixture of Experts (MoE) в 4 раза.

Новая платформа оснащена процессором Vera CPU с 88 ядрами, производительность которого вдвое превышает аналоги. Этот CPU специально разработан для инференса агентов и является самым энергоэффективным процессором для крупных AI-фабрик, с 88 кастомными ядрами Olympus, полной совместимостью Armv9.2 и сверхбыстрым соединением NVLink-C2C.

Графический процессор Rubin оснащен третьим поколением Transformer-движка с аппаратным ускорением адаптивного сжатия и обеспечивает 50 петафлопс вычислительной мощности NVFP4 для AI-инференса. Каждый GPU обеспечивает пропускную способность 3,6 ТБ/с, а стойка Vera Rubin NVL72 – до 260 ТБ/с.

Успешные испытания чипов

Дженсен Хуанг сообщил, что все шесть чипов Rubin вернулись от производственных партнеров и успешно прошли ключевые тесты, подтверждающие возможность внедрения по графику. Это заявление подчеркивает, что Nvidia сохраняет лидерство в качестве производителя AI-ускорителей.

Платформа включает пять ключевых инноваций: шестое поколение NVLink, Transformer-движок, доверительные вычисления, RAS-движок и Vera CPU. Третье поколение доверительных вычислений делает Vera Rubin NVL72 первой платформой на уровне стойки с защитой данных между CPU, GPU и доменами NVLink.

Второе поколение RAS-движка охватывает GPU, CPU и NVLink, обеспечивая мониторинг состояния в реальном времени, отказоустойчивость и проактивное обслуживание для максимизации производительности системы. Стойка выполнена в модульном исполнении с бескабельными лотками, что позволяет собирать и обслуживать её в 18 раз быстрее, чем Blackwell.

Широкая поддержка экосистемы

Nvidia сообщила, что Amazon AWS, Google Cloud, Microsoft и Oracle Cloud в 2026 году первыми внедрят инстансы на базе Vera Rubin, а облачные партнеры CoreWeave, Lambda, Nebius и Nscale также присоединятся к ним.

Генеральный директор OpenAI Сэм Альтман отметил: «Интеллект масштабируется с увеличением вычислений. Чем больше вычислений, тем мощнее становятся модели, решая более сложные задачи и влияя на людей. Платформа Rubin от Nvidia помогает нам продолжать этот прогресс».

Соучредитель и CEO Anthropic Дарио Амодей отметил, что повышение эффективности платформы Rubin от Nvidia «обозначает инфраструктурный прогресс, позволяющий реализовать более длинную память, лучшее рассуждение и более надежные результаты».

Генеральный директор Meta Марк Цукерберг заявил, что «платформа Rubin от Nvidia способна обеспечить скачкообразный рост производительности и эффективности, необходимый для внедрения передовых моделей среди миллиардов пользователей».

Nvidia также сообщила, что Cisco, Dell, Hewlett Packard Enterprise, Lenovo и Supermicro планируют выпустить серверы на базе Rubin. AI-лаборатории, такие как Anthropic, Cohere, Meta, Mistral AI, OpenAI и xAI, рассчитывают использовать платформу Rubin для обучения более крупных и мощных моделей.

Заранее раскрыты детали продукта

Комментаторы отмечают, что в этом году Nvidia раскрыла детали нового продукта раньше обычного — это часть стратегии компании по сохранению зависимости индустрии от её аппаратного обеспечения. Обычно компания подробно рассказывает о новых продуктах весной на GTC в Сан-Хосе, Калифорния.

Для Дженсена Хуанга CES — всего лишь очередной этап в его марафоне публичных выступлений. На разных мероприятиях он объявляет о продуктах, партнерствах и инвестициях, всё ради ускорения внедрения AI-систем.

Среди новинок Nvidia — сетевые и коммуникационные компоненты, которые станут частью суперкомпьютера DGX SuperPod, но также будут доступны отдельно для клиентов, желающих использовать их более модульно. Этот прирост производительности необходим, так как AI-системы уже стали более специализированными сетями моделей, которые не только анализируют огромные объемы данных, но и решают узкоспециализированные задачи в несколько этапов.

Nvidia активно внедряет AI-приложения во все сферы экономики, включая робототехнику, здравоохранение и тяжелую промышленность. В рамках этих усилий компания анонсировала ряд инструментов для ускорения разработки автономных автомобилей и роботов. Сейчас основная часть расходов на вычисления на базе Nvidia приходится на капитальные бюджеты немногих клиентов, среди которых Microsoft, Google Cloud (принадлежит Alphabet) и AWS (принадлежит Amazon).

Дисклеймер: содержание этой статьи отражает исключительно мнение автора и не представляет платформу в каком-либо качестве. Данная статья не должна являться ориентиром при принятии инвестиционных решений.

Вам также может понравиться

От ошибок к успеху: план возвращения Jack in the Box

Как Apollo с Уолл-стрит вновь оказался замешан в делах Эпштейна