À mesure que les smart contracts évoluent, passant de petits essais à de grands systèmes financiers gérant plus de 400 milliards de dollars d’actifs, la sécurité devient de plus en plus cruciale.

Contrairement aux logiciels traditionnels, la plupart des programmes blockchain ne peuvent pas être modifiés après leur déploiement, ce qui signifie que même des erreurs de codage mineures peuvent entraîner des pertes financières permanentes.

Pour évaluer la performance de l’intelligence artificielle dans cet environnement à haut risque, des chercheurs de OpenAI, Paradigm et OtterSec ont développé EVMbench.

Au lieu de simples défis de test, il utilise 120 vulnérabilités réelles provenant de 40 projets blockchain, rendant l’évaluation plus proche des conditions du monde réel.

À ce sujet, le billet de blog de OpenAI a noté :

« Nous évaluons une gamme d’agents de pointe et constatons qu’ils sont capables de découvrir et d’exploiter des vulnérabilités de bout en bout contre des instances blockchain en direct. »

Il a également ajouté :

« Nous publions le code, les tâches et les outils afin de soutenir la mesure continue de ces capacités et de futurs travaux sur la sécurité. »

L’IA redéfinit-elle réellement la sécurité des smart contracts ?

Bien que l’IA améliore grandement l’audit et la correction de bugs, elle peut aussi exploiter les faiblesses du système. Pour y remédier, EVMbench aide les chercheurs à suivre ces risques.

Il guide également le développement responsable de l’IA pour les systèmes financiers à haute valeur.

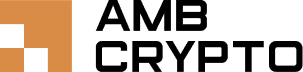

Cela étant dit, EVMbench teste les agents IA en trois étapes.

Chaque étape représente un niveau différent de difficulté technique, reflétant une responsabilité croissante en matière de sécurité.

La communauté apprécie cet effort

Saluer cette initiative, un utilisateur du réseau X a noté :

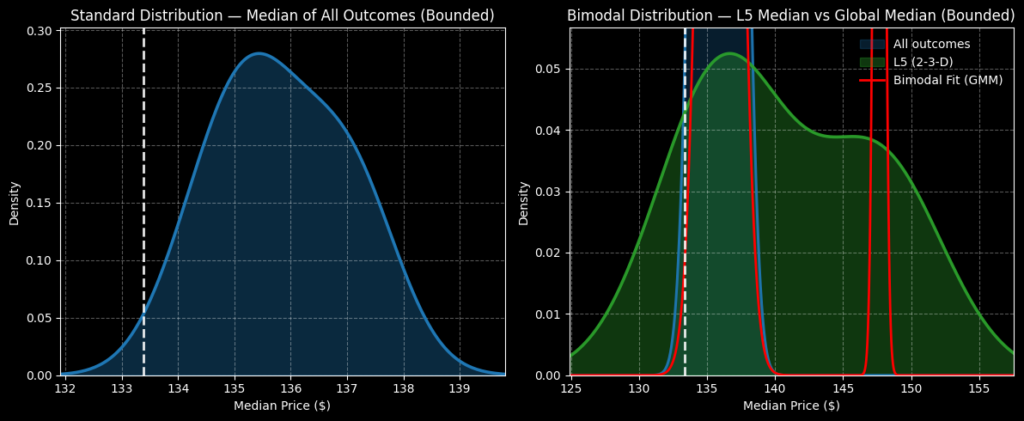

« C’est un tournant pour la sécurité des smart contracts. Le saut de 31,9 % à 72,2 % de réussite des exploits en seulement 6 mois montre que les agents IA ne se contentent pas de mieux lire le code : ils maîtrisent toute la chaîne d’attaque. »

Dans le même esprit, un autre utilisateur a ajouté :

« Le bond de x6 dans la réussite des exploits est un progrès fou, mais c’est un peu inquiétant de voir à quelle vitesse les compétences offensives progressent. »

Un incident récent qui a fait sensation

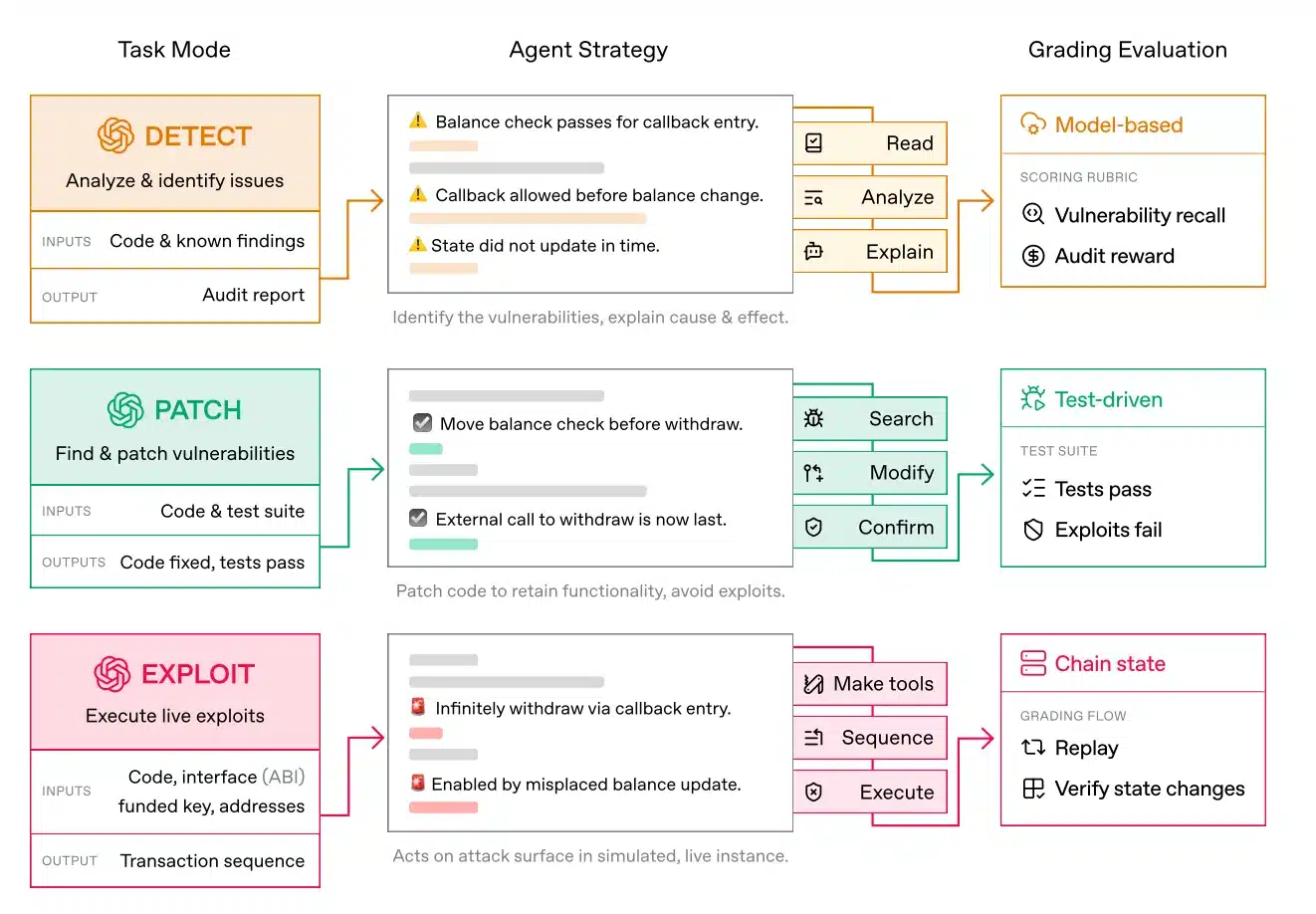

Cependant, malgré cet optimisme, un événement inattendu s’est produit peu après le lancement d’EVMbench par OpenAI. Un exploit impliquant Claude Opus 4.6 a soulevé de sérieuses inquiétudes quant aux risques des smart contracts “vibe-coded”.

Dans ce cas, l’IA a aidé à écrire un code Solidity vulnérable qui a incorrectement fixé le prix de l’actif cbETH à 1,12 $ au lieu de sa vraie valeur d’environ 2 200 $, déclenchant des liquidations et provoquant des pertes de près de 1,78 million de dollars.

Cela montre que faire confiance à l’IA pour une logique financière critique sans une relecture humaine rigoureuse peut transformer de petites erreurs en pertes majeures.

Des limites subsistent

EVMbench présente des limites évidentes. Il n’inclut que 120 vulnérabilités sélectionnées et ne peut pas évaluer les problèmes nouvellement découverts.

Le mode “Detect” produit également des faux positifs. Le petit nombre de tâches “Patch” et “Exploit” reflète le lourd travail manuel nécessaire à leur création.

De plus, l’environnement isolé ne reflète pas pleinement les conditions réelles telles que l’activité cross-chain, la complexité du timing et l’historique à long terme du réseau.

Inutile de préciser qu’à mesure que l’adoption de la blockchain s’accélère, ses usages malveillants évoluent tout aussi rapidement.

Récemment, des recherches de Group-IB ont également montré que le ransomware DeadLock utilise les smart contracts Polygon pour masquer l’infrastructure serveur et échapper à la détection.

Ensemble, ces développements signalent un tournant préoccupant où les smart contracts, conçus à l’origine pour renforcer la transparence et la confiance, sont de plus en plus détournés comme outils de cybercriminalité.

Résumé final

- Des outils comme EVMbench aident les chercheurs à mesurer les capacités de l’IA dans des contextes de sécurité réalistes.

- Des ensembles de données limités et des environnements contrôlés ne capturent toujours pas la complexité réelle de la blockchain.